우리는 AI 시대에 살고 있다.

대한민국 국민 절반이 AI 서비스를 경험했으며, 5명 중 1명은 생성형 AI를 업무나 학업에 적극 활용하고 있다. 최근 통계에 따르면, AI가 매우 친숙해진 시대이다. (1)

전문가들은 AI가 단순 정보 획득 단계를 넘어섰다고 말한다. 이제는 인터넷 없이 생활하기 어려운 것처럼, AI 없이는 기본 생활이 불가능한 수준에 이르렀다고 분석한다.

그렇다면 AI 시대를 살아가는 우리는 AI를 어떻게 느낄까?

개인적으로 인터넷 태동기를 겪어본 나로서 지금은 그때와 확실히 다른 느낌이 든다. 인터넷은 전 세계를 하나로 연결해 주는 하나의 도구이자 기술이라는 느낌이 컸다면, 지금의 AI는 인류가 다른 과도기로 넘어가고 있는 ‘인류 역사상 중요한 터닝 포인트’ 란 생각이 든다.

빠르게 발전하는 AI는 때때로 두렵게 느껴진다. 나만 그런 것일까?

그렇지 않다. 최근 미국 언론사의 조사에 따르면 66%가 AI로 인한 불안감과 공포를 느끼고 있다고 답했다. 왜 그럴까?

그저 AI를 제대로 배우지 못했다는 불안감, 남들보다 뒤쳐진다는 초초함 등의 개인적인 이유보다 더 보편적이고 설득력 있는 이유가 있을 것이다. 그래서 찾아보았다. 몇 주간 최근 논문과 심리학 전문가의 글을 찾아 읽으며 왜 우리가 본능적으로 AI를 두려워하는지 그 명쾌한 답을 찾아보았다.

[AI시대 왜 당신은 불안한가? 심리학자가 말해주는 설득력 있는 이유 3가지]는 AI 분야에 관심 많은 독자뿐만 아니라 심리학에 흥미를 갖는 분, 그리고 현재를 어떻게 살아나가야 할지 모르는 당신에게 읽어볼 만한 정보를 제공해 줄 것이다.

AI 시대, 66%는 불안감을 느낀다.

미국의 언론사단체인 뉴스미디어연합(NewsMedia Alliance)이 1,800명을 대상으로 한 ‘AI 실태 조사’를 실시했다. 이 조사는 AI가 정치적·사회적으로 어떤 영향을 미치며, 지적 재산권 보호 및 제도적 규제 감독의 필요성을 묻는 최초의 여론 조사라는 점에서 그 의미가 있다.(2)

여론 조사 내용 중 가장 눈여겨볼 점은 AI에 대해 어떻게 생각하느냐에 대한 질문이다. 전체 응답자 중 66%가 AI의 급속한 발전 불편하다는 부정적인 답변을 내놓았다. 세부적으로는 여성(71%), 정치적 보수주의자(71%), 노인(81%), 농촌거주자(77%) 등이 상대적으로 AI에 대해 부정적 인식이 더 강했다.

그렇다면 한국의 경우는 어떨까?

과학기술정보통신부의 최근 보고서, 『2023 인터넷이용실태조사 』에 의하면, 미국의 경우와 상당히 다른 반응을 보여준다.

설문조사 응답자의 60.7%가 AI가 사회전반에 긍정적 영향을 줄 것이라고 응답했으며, 분야별 AI 서비스를 경험해 본 응답자들 80% 이상이 AI 서비스가 해당 일상 분야에 큰 도움이 되고 있다고 말했다.

더욱이, ‘고기도 먹어 본 사람이 많이 먹는다’라는 옛 속담처럼 AI 서비스를 경험해본 사람들이 AI를 전혀 접해보지 않은 미경험자들보다 AI를 더 좋게 생각하고 있다는 점이 흥미롭다.

왜 미국에 비해 한국이 AI에 관대한 것일까?

그 이유는 대도시 중심의 지식 집약적 거주 환경, 새로운 기술 습득이 빠른 한국인 특성, 인터넷 기술이 녹아든 대중교통과 주거환경, 문화 등에 일찍 노출되어 첨단 기술에 대한 거부감이 줄어들었기 때문이라고 생각된다. (3) ( ‘AI 실태 조사‘에 대한 더 자세한 세부 내용은 아래 슬라이드에서 확인해 볼 수 있다.)

하지만 한국에서의 ‘AI에 대한 압도적인 긍정적인 인식’에도 불구하고, 위험한 인공지능을 금지하고 처벌하는 규제가 필요하다는 목소리가 나오고 있다.

정부차원에서 AI를 규제하다.

너무 빠른 AI 발전 속도는 울타리를 넘어 질주하는 말과 같다

하지만 유럽연합(EU)은 더 이상 AI가 통제되지 않는 상황을 방치하지 않고, 세계 최초로 고위험 인공지능을 포괄적으로 규제하는 인공지능법안을 합의하여 더 늦기 전에 통제하기로 결심했다.

이 법안은 AI의 위험 수준을 지정하여 ▲허용할 수 없는 위험 ▲고위험 ▲저위험 ▲최소한의 위험으로 구분하고, 허용할 수 없는 위험은 금지하며, 고위험 AI에는 철저한 요구사항을 부과하는 등 고강도의 AI 규제를 포함한다.

특히, 부과된 의무를 위반하는 인공지능 사업자에 대해서는 전 세계 매출액의 최대 7%에 달하는 높은 제재를 할 것이라는 조항이 포함되어 있어, 이 법안이 유럽뿐만 아니라 전 세계에 큰 영향을 미칠 중요한 이정표로 간주된다. (5)

그렇다면 우리나라의 경우는 어떨까?

결론부터 말하면, 한국은 ‘우선 허용, 사후 규제’ 방침을 중심 기조로 잡고 있다. 정부와 국회는 인공지능 관련 산업계의 요구 사항을 먼저 들어주고, 문제가 발생하면 나중에 처리하겠다는 입장이다. 이는 ‘소 잃고 외양간 고치기’와 같다는 전문가와 참여연대의 비판을 받고 있다.(6)

그 이유는 국민의 안전과 기본권을 보호해야 하는 정부가 그 역할을 소홀히 하고 있기 때문이다. 최근 범용 인공지능 논란에 대한 정부의 대책 부재를 보면, AI로 인한 개인의 금전적, 정신적 손해에 대한 정부의 보상 기대가 어렵다는 주장이다.

정부는 이러한 비판에 대해 다음과 같이 대처하고 있다.

EU는 생성형 AI를 포함한 파운데이션 모델(FM)을 고위험 AI처럼 강하게 규제하고 있습니다. 하지만, 우리나라의 경우 수많은 AI 스타트업이 생성형 AI 개발에 본격적으로 뛰어들고 있고 있는 시점 아닙니까? 지금 국가 차원에서 전폭적인 지원을 해줘도 모자를 판국에 섣불리 EU처럼 ‘고강도 규제’를 도입하는 것은 신중할 필요가 있어 보입니다.

방향성은 일부 참고 할 수 있겠죠. 하지만 고강도 규제를 하는 것은 현재 우리가 처한 상황하고는 전혀 맞지 않는 부분이 있습니다. 물론, EU AI법의 규제와 관련된 내용을 참고는 하겠지만, 2020년에 나온 미국의 법도 참고하는 하이브리드 성격으로 가야 하지 않나 싶습니다”

AI발전이 가져올 불길한 걱정거리들

AI 발전이 가져올 불길한 걱정거리들. ‘우선 허용, 사후 규제’라는 한국의 AI 방침에 대해 어떻게 생각하는가? 나는 이런 정부 입장이 바람직하지 않다고 생각한다. 그 이유는 AI 발전이 가져올 불길한 걱정거리들 때문이다.

AI전문가는 이렇게 말한다.”인공지능은 무어의 법칙을 넘어섰다.” 이 내용은 다음과 같다.

무어의 법칙이 기술 발전의 길잡이 역할을 해왔지만, AI는 이를 넘어 새로운 기준을 제시하고 있다. 이 기준은 예측 가능한 미래를 벗어나 ‘상상도 못했던 역동적이고 혁신적인 미래’로 이동하게 할 것이다. AI는 인터넷과 스마트폰에 버금가는 혁신적 기술이며, 인류의 새로운 도약을 위한 발판이 될 것이다.

멋진 말이다. 그러나, 상상도 못한 역동적이고 혁신적인 미래가 우리에게 항상 좋은 파라다이스를 만들어줄까?

EU의 ‘인공지능법안’(AI Act)은 이에 대한 명확한 답을 내놓았다. ‘결코 좋지 않을 것이다. 그렇기때문에 지금부터 막야아한다.’

그렇다면, EU가 우려했던 AI 발전이 가져올 불길한 걱정거리와 우리가 AI 시대에 불안해하는 이유를 본격적으로 알아보자.

1-1. 선택과 결정할 수 있는 통제력 상실

AI가 인간보다 더 발전하고 유능해짐에 따라 인간의 의사 결정 권한이 기계에 위임될 것이다. 이러한 상황이 지속되면 인간의 주도권과 결정권은 자연스럽게 사라질 것이다.

이런 충격적인 내용과 관련된 최근 AI 연구 몇 가지를 소개한다.

첫 번째 실험은 인간이 의사결정 과정에서 AI에 얼마나 의지하는지 알아보는 것이었다. 결과적으로, 선택 시간이 줄어들수록 AI에 더 많이 의지하는 경향을 보였다. 그 이유로 의사 결정 과정에서 시간적 압박으로 스트레스를 받는 상황에서 이를 해소할 수 있는 의사 결정 지원도구인 AI에 의존한다는 분석이다.(7)

다른 유사한 실험은 AI를 얼마나 신용할 수 있는지 알아보기 위해 참가자를 모집했다. 그 결과 사람의 성격과 성향에 따라 얼마만큼 AI를 믿을 수 있는지 그 신용도가 다르게 나타났다. 그러나, 공통적으로 재정과 의료 등 자신에게 중요하다고 생각하는 AI 정보를 더 많이 신뢰했다.

더 흥미로운 점은 AI가 제시한 중요 정보가 자신의 생각과 일치하면 AI를 더욱 신뢰하는 경향이 나타났다. 예를 들어 AI가 하루 한 잔의 와인은 건강에 좋다는 정보가 자신 음주습관과 일치했다면 AI 정보를 더욱 신뢰했다. (8)(9)

결론적으로, 결론적으로, 시간이 촉박하고 중요한 일에 결정을 내려야 할 때, 자신의 생각과 신념이 AI 정보와 일치하면 AI 정보를 더욱 신뢰하고 의지하는 경향이 있다.

위의 연구는 잠시 제쳐두고 오늘 했던 일을 생각해보자. AI 알고리즘이 추천한 음악을 듣고, 영상을 시청하며, AI 추천 상품을 구입하지 않았는가?

이런 소소한 일은 시작에 불과하다. 몇 년 안에 AI는 진로와 직업, 데이트와 결혼, 자녀 계획과 주거지 등 모든 것을 계획하고 선택해 줄 것이다. 우리는 모든 것을 AI에 의지하면서 인간만의 고유한 의사결정 권한과 능력을 점차 상실하게 될 것이다.

사안이 급박하고, 중요하고, 더욱 위험할수록 AI의 제안에 크게 의존하는 경향을 보인다.

1-2. AI가 인간을 해칠 수 없도록 통제하기란 불가능

AI가 인간 지능을 뛰어넘어 결국 인간은 종속화될 것이다.

AI가 인간 지능을 뛰어넘어 인간을 종속화시킬 것이다. 이론물리학자 스티븐 호킹(Stephen Hawking), 사업가 엘론 머스크(Elon Musk) 등 많은 과학기술 지도자들은 일찍이 AI의 위협을 경고했다. 특히, 옥스퍼드대 철학과 교수 닉 보스트롬(Nick Bostrom)은 지금부터 AI를 통제하지 않으면 디스토피아를 피할 수 없다고 경고한다.

보스트롬 교수는 초지능 AI가 곧 등장할 것이며, 인류를 위협하지 않도록 초지능 AI를 통제하는 알고리즘을 만드는 것은 불가능하다고 설명한다. (10)

마찬가지로, MIT 교수 이야드 라환(Iyad Rahwan)은 컴퓨터 과학의 기본 법칙을 근거로 AI가 세상을 파괴하지 못하도록 명령하는 프로그램이 의도치 않게 자체 작동을 멈추게 할 수 있다고 말하며, AI 통제가 불가능함을 강조한다.

초지능(superintelligence)이 인간의 지능 수준에 도달하는 시기가 올 것이다. 그 시점이 되면 AI 기술은 폭발적으로 발전하여 한 순간에 AI가 인류를 넘어서는 초지능 시대에 도달할 것이다.

현재 인류는 AI를 어떻게 통제할 것인가에 대해 심각하게 고민해야 하는 중요한 시점에 놓여 있습니다. 인류가 초지능 AI의 혜택을 누리려면 AI를 원하는 방향으로 설계할 수 있어야 합다.

닉 보스트롬(Nick Bostrom), 옥스퍼드대 철학과 교수

통제불가능한 AI를 다룬 영화들

통제 불가능한 AI를 다룬 영화들. AI라는 용어가 처음 등장하기 전, 독일의 프리츠 랑 감독의 1927년 작품, ‘메트로폴리스(Metropolis)‘에서 이미 인공지능 개념이 등장했다. 그만큼 AI는 SF 영화의 흥미롭고 매력적인 소재로 다루어져 왔다. 특히, AI의 폭주로 인류가 위협받는다는 설정은 AI에 대한 대중의 인식에 큰 영향을 미쳤으며, AI를 둘러싼 윤리적 및 철학적 문제를 탐구하게 만들었다.

엑스 마키나

고용주의 초대를 받은 프로그래머가 첨단 휴머노이드 AI에 튜링 테스트를 진행하며 인간과 AI 사이의 조작, 의식, 신뢰에 대한 질문을 던진다. 이 영화는 심리적이고 친밀한 시각으로 AI 주제를 탐구한다.

타우

Front Content Here

미래형 스마트 하우스에 갇힌 한 여성이 집을 제어하는 컴퓨터 프로그램에 침입해 탈출을 시도한다. 모든 것을 자동화하도록 설계된 인공지능 타우는 이 여성으로부터 학습하기 시작하며 예상치 못한 전개로 이어진다.

이글아이

Front Content Here

미국 정부가 자국민에게 위협이 된다고 판단한 인공지능 슈퍼컴퓨터 아리아는 방대한 통제권을 활용해 민간인을 조종하고, 정부 리더십을 재편하기 위한 치명적인 계획을 실행한다. 이 영화는 AI가 인간의 행동을 대규모로 조작하고 통제할 때 발생할 수 있는 실존적 위협을 잘 보여준다.

코로나19 이후 비대면 사회가 본격적으로 시작되면서 우리는 매일 방대한 양의 데이터를 생산하고 전송하며 살아왔다. 그리고 ‘AI의 등장’은 데이터를 21세기 최고의 자본으로 탈바꿈시켰다.

전문가가 아니더라도 데이터를 학습하고 그 패턴을 파악해 최적의 결과를 만들어내는 AI야말로 ‘황금알을 낳는 거위’와 같다는 의견에 모두 동의할 것이다. 그만큼 시대가 크게 바뀌었다.

그러나 황금알을 낳는 거위를 국가, 권력기관, 또는 개인이 사적인 용도로 악용한다면 어떻게 될까? AI 악용은 다음과 같은 큰 문제를 초래했다.

2-1. 국가 차원의 AI 악용

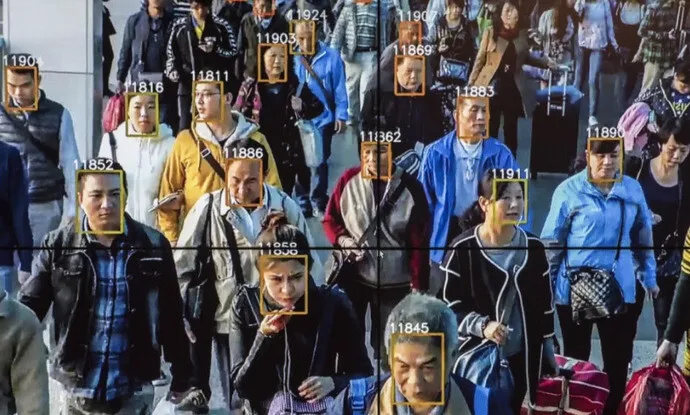

국가 또는 권력기관은 ‘안전’을 명분으로 사생활 감시에 AI를 철저히 이용한다. 대표적인 예로 조지 오웰의 디스토피아 소설 1984에 등장하는 권력집단 빅 브라더의 실사판이라고 불리는 중국이 있다.

중국 당국은 어떤 범죄자도 빠져나갈 수 없는 세계 최대의 감시 카메라망으로 2억 명 중 특정인을 찾는 데 몇 초면 충분하다고 자랑한다. 실제로 상하이 지하철에 안면인식 시스템을 도입해 석 달 동안 용의자 567명을 적발했으며, 선글라스 형태의 웨어러블 AI 기기를 이용해 인신매매 및 뺑소니 범죄 용의자 7명과 신분 위조 용의자 26명을 적발했다. (11)

이와 같이 중국 당국은 AI 사용을 치안을 위해서라고 강조한다. 그러나 막강한 감시망을 통해 사생활 감시와 사회 통제를 하려는 것 아니냐는 우려도 커지고 있다.

예를 들어, 주요 도시 교차로를 무단횡단한 주민은 안면 인식기와 연동된 스크린에 얼굴과 집 주소, 개인 연락처 같은 개인 정보가 공개되어 사회적 망신을 당한다. 동시에, 사회신용 시스템(Social Credit System)에서 점수를 감점당해 취업, 신용카드 할부, 은행 대출, 무료 건강 검진 등에서 불이익을 받게 된다. (12)

또한, 안면 인식 시스템은 소수 민족 통제에 사용되고 있다. 중국은 안면 인식 시스템으로 신장 위구르 자치구 주민 100만 명의 일거수일투족을 감시하고 있다. 중국 당국은 이를 부인했지만, 소수 민족과 반정부 인사 감시에 안면 인식 기술을 악용하고 있다는 국제 인권 단체들의 의심은 해소되지 않고 있다.

2-2. 개인적 차원의 AI 악용

국가 차원의 AI 남용은 개인정보 유출과 프라이버시 문제를 넘어 인권을 무시하고 사회를 통제하는 수단으로 쓰일 수 있다. 그렇다면 개인이 AI를 악용하면 어떤 일이 발생할까? 대부분 ‘사기’라는 단어가 가장 먼저 떠오를 것이다.

개인이 AI를 악용해 사기 범죄를 벌인 최초의 사건은 2019년 3월에 발생했다. 사이버 범죄자가 독일 모회사의 CEO 음성을 거의 똑같이 따라 하는 음성 변조 AI를 이용해 직원에게 22만 유로를 요구하고, 추적이 불가능한 가상 계좌로 송금받은 사건이다.

5년이 지난 현재, 딥러닝(Deep Learning)과 가짜(Fake)의 합성어인 딥페이크(Deep Fake) 영상은 AI 확산 이전보다 550% 증가했다. 테러, 가짜 뉴스, 금융 사기, 개인정보 절취 등 AI 악용 범죄로 전 세계에서 입은 피해액은 1500억 달러(약 190조 500억 원)에 육박한다. (13)

국내 전문가들은 유명인 사칭 온라인 사기 광고부터 시작해 가족의 얼굴과 목소리로 영상 통화를 걸어 금전을 요구하는 등의 AI 범죄 피해 사례가 3년 사이 10배 이상 폭증했다고 지적한다. 진실과 거짓의 경계가 모호해지고 누구도 쉽게 믿을 수 없는 불신의 사회가 만들어지고 있다는 우려도 제기된다.

딥페이크 사기가 만들어내는 불신의 사회.

심리학자들은 AI 사기가 사람들의 인식을 크게 바꾸고 기본적인 사회적 신뢰를 약화시킨다고 걱정한다. 최근 연구에 따르면, 개인의 이익을 위해 AI를 악용하는 사기가 금전적 손실뿐만 아니라 정신적, 사회적 침체를 초래한다고 한다. (14)(15)(16)

신뢰의 침식

냉소주의 증가

사회적 비용 확대

딥페이크 기술은 커뮤니케이션에서 신뢰와 진정성의 토대를 무너뜨려 사회적 유대와 결속을 약화시킨다. 이러한 사회에서 개인은 긴장과 갈등 속에 정신적 질환에 걸리기 쉽다. 집단의 경우 이혼율, 자살률, 범죄율 등이 증가하여 결국 사회가 붕괴되는 극단적 상태에 이를 수 있다.

정부 체제, 사회 조직, 인간 관계, 국민성, 기타 정책 등을 쉽게 믿을 수 없기 때문에 모든 것을 비난하거나 자조하면서 ‘구경꾼의 세계’속으로 숨는다. 구경꾼은 “이제 모르겠다”, “될 대로 되어라”, “이대로 망해버려라” 등 세상만사를 비관적으로 바라보며 문제에 대한 어떤 대안을 제시하려 하지 않는다. 이러한 분위기는 온라인에서 인신공격성 댓글과 비방, 명예 훼손, 조롱 등을 부추긴다.

딥페이크는 보안에 대한 잠재적 위협과 신뢰 위기를 만들어낸다. 따라서 개인뿐만 아니라 국가적 차원에서 딥페이크 기술의 진위여부를 알아내는 시스템 구축이 필요하며, 구축에 필요한 비용은 ‘사회적 비용’으로 그 비용은 연간 연간 30조 원에 달한다. 결국 우리는 AI 사기에 당하지 않기위해 각자가 불필요한 추가 세금을 내고 있다고 보면 된다.

2-3. 의도치 않은 AI 악용

AI를 활용하면 능률과 효율을 높이고 비용을 절감할 수 있다. 그러나 AI를 다양한 분야에서 더 많이 활용할수록 의도치 않은 문제들이 발생할 수 있다. 불행히도, 현재 AI가 만든 문제들에 대해 명확한 해결책이 없다.

예를 들어, 증권가 AI 알고리즘이 잘못된 증시 정보를 분석해 특정 주식을 대량 매수했다면 그 책임은 누구에게 있을까? AI로 5분 만에 만든 창작물이 국제 대회에서 대상을 받았다면 누구의 실력을 인정해야 할까? AI가 사무직 일자리를 모두 대체한다면 해고당한 사람은 어떻게 사회생활을 해야 할까?

AI 전문가는 이러한 질문에 대한 해결책을 찾기 어려운 이유로 복잡한 윤리적, 법적, 사회적 고려 사항이 수반되기 때문이라고 설명한다. 그렇다면 AI 사용으로 발생하는 의도치 않은 문제점들을 자세히 살펴보자.

2-3 A. AI가 내린 결정. 책임소재 누가에게?

그동안 인간이 하던 일을 AI와 로봇이 대체하면서 기업들은 책임의 주체를 인간에서 기계로 넘어갔다. 그러다 보니 인공지능이 잘못된 결정을 내렸을 경우 그 법적 책임을 누가 져야 할지 문제가 발생한다. 대표적인 예로 다음 사건이 있다.(17)

# 테슬라, 자율주행 중 충돌사고로 운전자 사망

2016년 5월 미국 플로리다에서 자율주행 중이던 테슬라 모델 S가 트레일러와 충돌해 운전자가 사망한 사고가 발생했다. 테슬라는 자율주행 시스템이 오류를 일으킬 수 있으며, 운전자는 항상 핸들에 손을 대고 있어야 한다고 사전에 경고했지만, 사고 당시 운전자는 주의를 기울이지 않고 영화를 시청하고 있었다.

미국 자동차교통국은 테슬라의 책임을 인정하지 않았고, 테슬라는 자율주행 시스템이 인간 운전자보다 안전하다는 주장을 굽히지 않았다. 이 사건 이후 자율주행 시스템을 사용하려면 규제당국의 허가가 필요하게 되었으며, 자율주행 기술의 법적 책임과 안전성에 대한 논란은 여전히 계속되고 있다.

위의 사례를 좀 더 깊이 살펴보자. AI로 인해 제조사가 법적 책임을 질 경우는 다음과 같다. 의도하지 않았고 발견하지 못한 디자인 결함이 있을 경우, 그리고 그 결함을 소비자에게 미리 공지하지 않거나 고의적으로 숨겼을 경우.

따라서 운전자는 자율주행에만 의존해서는 안 되며, 핸들 위에 손을 올려놓아야 한다는 공지를 무시했기 때문에 발생한 사고이므로 테슬라는 법적 책임을 질 필요가 없다.

그러나 법적 책임 문제를 떠나, 인간의 실수에 취약한 제품을 만들어 판매해도 문제가 없느냐는 도덕적 딜레마가 있다면 테슬라는 할 말이 없다. 예를 들어, 모든 것을 잘라낼 수 있는 매우 날카로운 식칼을 디자인하는 제조업체를 생각해 보자.

신소재로 만들어진 무서울 정도로 날카로운 식칼. 잘못 다루면 심각한 부상을 입기 쉽다는 의미이기도 하다.

제조업체는 칼의 날카로움을 광고하면서도, 소비자에게 ‘매우 날카로우니 조심해서 다루세요’, ‘아이 손에 닿지 않는 곳에 안전하게 보관하세요’라는 안전 문구를 작게 표시해 법적 책임을 회피했다. 그러나 결국 우려하던 주방 사고는 지속적으로 발생했다.

제조업체는 소비자에게 잠재적 위험성과 적절한 취급 지침을 알려줌으로써 법적으로 보호받을 수 있다. 그러나 칼의 성능이 매우 뛰어나다고 해서 안전을 고려하지 않은 제품이 과연 좋은 제품인지 의문이 남는다. ‘자동주행 기능이 있는 테슬라 차량’도 마찬가지다.

아무리 AI 기능이 편리함과 안락함을 가져다줄지라도 그 제품의 안전성과 인공지능 윤리(AI Ethics)까지 충분히 고려되어야 한다. 그러나 이윤 추구가 최대 목적인 기업이 과연 이를 제대로 따를까?

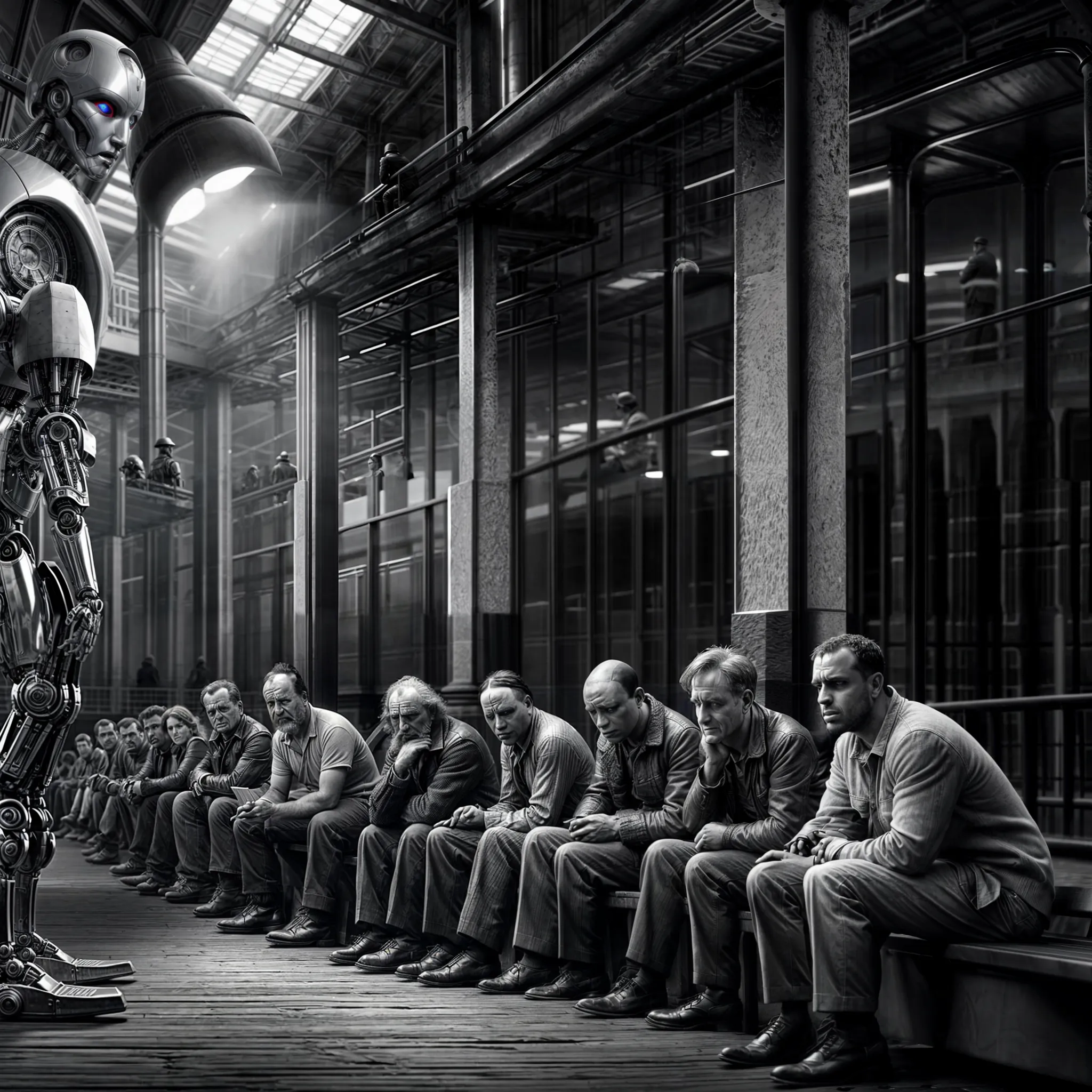

2-3 B. 기존 노동시장의 붕괴. 누가 책임지나?

인공지능의 급속한 발전으로 인해 일자리의 미래에 대한 우려가 커지면서 고용 시장에 지각변동이 일어나고 있다. 최근 전 직원의 약 6%인 1만2천 명을 해고한 구글, 1만7천 명을 구조조정한 아마존 등 빅테크 기업의 충격적인 행보는 ‘AI가 사람의 일자리를 빼앗을 것’이라는 소문이 거짓이 아님을 보여줬다. 이를 지켜본 많은 이들이 AI가 기존의 노동 시장을 붕괴시키고 소비 시장을 무너뜨려 새로운 대공황이 올 것이라며 비관적인 전망을 내놓았다.(18)

사실, 새로운 기술의 등장으로 기존 일자리 판세가 바뀌는 현상은 어제오늘 일이 아니며, 기존의 일자리가 위협받으면 사람들이 얼마나 불안해하고 비이성적으로 행동할 수 있는지 역사를 통해 잘 보여줬다.

『 보이지 않는 기계 세대(Age of Invisible Machines)』의 저자이자 AI 전문가, 롭 윌슨(Robb Wilson)은 이러한 역사적 사건들을 지적하면서 기술의 발전으로 기존의 일자리가 없어지는 현상은 일시적인 것이라고 말한다.

그는 오히려 단순 반복적인 생산 업무를 AI가 대신함으로써 사람들이 가장 즐거워하는 일, 가장 잘하는 일을 찾을 자유를 갖게 될 것이라며 지금의 걱정과 불안은 기우에 지나지 않는다고 주장한다. 그는 마지막으로, AI와 관련된 새로운 일자리가 생겨나면서 주 40시간 근무 환경과의 결별, 잉여 자원의 증대, 의료 분야의 질적 개선, 삶의 질 향상 등 긍정적인 미래를 예측한다.(19)

AI가 인간의 역량을 강화하고 지루한 업무에서 해방시켜 줄 것이라며 장밋빛 미래를 그리는 롭 윌슨.

그러나, 반대되는 생각을 가진 AI 전문가도 있다. MIT의 물리학자이자 삶의 미래 연구소(Future of Life Institute)의 공동 설립자인 맥스 테그마크(Max Tegmark)는 현재 AI가 러다이트 운동이나 스윙 폭동 때보다 더 큰 사회적 혼란을 야기할 수 있다고 다음과 같은 근거를 든다.

- AI는 단순 노동뿐만 아니라 지식 노동, 더 나아가 전문직 영역까지 대체할 수 있다. 특히, 최고경영자, 관리자, 의사, 변호사, 펀드매니저 등 화이트칼라 영역의 일자리는 AI로 대체될 것이며, 지식층만의 특권이라고 여겨졌던 일자리의 소멸은 사회적 혼란을 야기할 것이다.

- ‘이윤 증대’가 자본주의 경제의 기본 속성인 만큼 노동력이 AI로 대체되는 현상을 막는 것은 불가능하다. 그러나 ‘AI는 소비를 하지 않는다’는 중요한 사실을 잊어서는 안 된다. AI가 일자리를 가져감으로써 소비 시장은 위축되고, 붕괴되어, 결국 대공황으로 이어질 수 있다.

요컨대 기술 혁신으로 일자리가 사라지고, 그 사라진 공백을 새로운 일자리가 채울 것이라는 점에는 AI 전문가 모두가 동의한다. 그러나 일어날 일에 대한 추측은 서로 다르다.

나는 매우 부정적이다. AI가 일자리를 가져감으로써 얻는 이득이 모든 사람에게 공평하게 나눠질 것이라는 생각은 ‘해피엔딩으로 마무리되는 동화 속 이야기’일 뿐이다. 결국 상위 10%만이 그 이익을 독식할 것이며 더 많은 사람이 가난해질 것이라고 생각한다.

따라서 ‘인간이 만든 도구’에 불과한 인공지능을 누가, 어떻게, 어디까지 사용할지에 따라 우리의 미래가 유토피아 혹은 디스토피아로 향할지 결정될 것이다.

관련 포스터

인생이 힘든 이유 6가지

내 인생은 왜 이렇게 힘들까?

AI가 개인과 사회에 미치는 심리적 영향은 심각하고 다면적일 것이다.

AI 기술에 적응하는데 따른 스트레스와 불안감의 증가부터 전통적으로 인간이 수행하던 역할을 기계가 대신하면서 오는 정체성, 자존감, 사회적 단절과 같은 더 깊은 문제까지 다양한 우려가 제기되고 있다. 또한 사생활 침해와 함께 AI가 사회적 편견을 악화시킬 수 있다는 우려도 존재한다.

그 외에도, 업무의 자동화로 인해 일자리가 사라지고, 이에 영향을 받는 사람들은 스트레스와 정체성의 위기를 겪을 수 있으며, AI가 투명한 메커니즘 없이 행동을 조작하거나 영향을 미칠 수 있는 방식은 불신이나 편집증을 조장할 가능성도 있다.

다음은 AI로 인해 인간이 겪을 심리적, 정신적 불안 증세를 자세히 다룬다.(20)

AI 시대의 대표적인 정신장애

인간으로서 우리는 본질적으로 “부정편향(negativity bias)”이라는 성향을 지니고 있다. 나쁜 것이 좋은 것보다 더 매력적이고 그쪽으로 달려가고 싶은 충동은 부정편향이 우리 머릿속에 자리 잡았기 때문이다. 그래서 우리는 애매한 상황을 부정적이고 안 좋은 것으로 해석한다. 또, 긍정적인 정보와 부정적인 정보를 모두 접해도 부정적인 내용에 더욱 민감하게 반응한다.

그렇기 때문에 불확실성으로 가득 찬 AI시대에는 부정적 편견을 가진 개인이 더욱 취약할 수밖에 없다. 통제할 수 있는 확실한 것이 없으니 스트레스를 받을 수밖에 없다. 더욱이, 부정적인 콘텐츠를 부곽 시키는 경향이 있는 AI 시스템은 인간의 의식과 감정에 상당히 부정적인 영향을 미칠 것으로 예상된다.

그 밖에도 다음의 대표적인 정신 장애들이 인간의 정신을 피폐하게 만들 것이다.

1.테크노 스트레스

2.고립감과 외로움

3.정체성과 자존감 결여

4.편집증과 불신

5.강박 및 중독성 행동

6. 적응 장애

테크노 스트레스(Technostress)는 새로운 기술에 압도당했을 때 발생하는 불안, 긴장 또는 고통의 감정을 일컫는다. AI 시스템이 직장과 일상 생활에 더 많이 도입됨에 따라 일부는 너무 빠른 적응 속도에 적응하지 못하고 도태될 수 밖에 없다. 그리고 그들은 이로 인해 스트레스로 정서적 불안증세를 겪을 가능성이 높다.

AI는 100% 원격근무를 가능하게 하여 개인이 굳이 회사에 나갈 필요성을 없앤다. 또한, 병원, 학교, 종교단체를 가지 않아도 VR을 통해 모든 활동이 가능하기에 사회적 인간관계는 축소될 수밖에 없다. 이러한 현상은 고립감과 외로움을 유발하고 대인 기피 증세를 겪을 가능성을 높인다.

인공지능이 기존에 인간이 담당하던 업무를 대신하면서 직장을 갖지 못하고 사회에 적응하지 못하는, 이른바 ‘쓸모없어진 사람들’이 더욱 많아질 것이다. 그들은 ‘쓸모없다’는 낙인으로 인해 자존감이 한없이 떨어지고, 자신이 갖고 있던 가치관이 흔들리면서 살아가는 목적의식을 잃고 방황하게 될 것이다.

AI가 자신의 행동을 감시, 기록, 심지어 조작할 수도 있다는 생각은 특히 디지털 감시와 데이터 프라이버시 문제를 경계하는 사람들 사이에서 편집증과 불신으로 이어질 수 있다. 이러한 우려는 개인의 사생활 침해와 정보 오용 가능성에 대한 두려움을 더욱 증폭시킨다.

특히 소셜 미디어와 게임 분야에서 AI 기반 플랫폼이 확산됨에 따라 디지털 중독이 증가할 수 있다. 사람들은 AI 기반 상호작용에 지나치게 의존하거나 집착하여, 이것이 없으면 불안하고 초조해하는 등의 부작용에 시달릴 것이다. 결국 이는 사회적 상호작용의 감소와 정신 건강 문제를 초래할 수 있다.

AI 기술이 발전하고 사회적 규범과 고용 시장에 혼란을 일으키기 시작하면서 많은 사람들이 적응 장애를 경험할 것이다. 이 상태는 개인이 기술로 인한 중대한 변화와 같은 특정 스트레스 요인에 대처하거나 적응하는 데 어려움을 겪을 때 발생한다. 결과적으로, 빠르게 변화하는 환경을 헤쳐 나가면서 정신 건강 문제가 증가할 수 있다.

마무리 – AI를 마냥 긍정적으로 봐야할 것인가?

AI는 인류를 한 단계 도약시킬 만큼 위대한 기술임은 분명하다. 그러나 많은 영역에서 AI가 인간의 능력을 뛰어넘을 것이라는 기대감은 오히려 AI에 주도권을 빼앗길 것이라는 두려움으로 변질되었으며, 이제는 AI로 인해 새로운 형태의 스트레스를 만들어내고 있다.

AI를 마냥 긍정적으로 봐야 할 것인가?

나는 ‘아니다’라고 확신한다. AI 통제 불가능, AI의 악용과 AI가 가져올 심리적, 정신적 장애 등은 AI 시대가 호락호락하지 않을 것을 경고하고 있다. 그렇기에 지금 유럽 연합에서 실시한 ‘인공지능법안(AI Act)’이 ‘AI로부터 인류를 지키기 위한 위대한 선례’로 기록될 것이라고 확신한다.

물론, 일어나지 않은 일을 너무 부정적으로 볼 필요는 없다. 그러나, AI 시대가 가져올 불행에 미리 대비하지 못한다면 AI에게 몸과 마음이 지배당하는 날이 반드시 올 것이다.

마지막으로 긴 글을 끝까지 읽어주신 당신에게 늘 마음의 평안과 행복이 가득하길 빈다.

출처

- 1) 노도현 기자, 국민 절반은 AI 서비스 경험했다…생성형 AI 경험도 5명 중 1명, 경향신문, 2024/3/28

- 2) News/Media Alliance Survey Reveals Support for AI Companies to Compensate Publishers, News/Media Alliance, 4/9/2024

- 3) News/Media Alliance Survey Reveals Support for AI Companies to Compensate Publishers, News/Media Alliance, 4/9/2024

- 4) 2023 인터넷이용실태조사, 과학기술정보통신부, 2024/3/29

- 5) 임주리 기자, 유럽의회, 세계 첫 AI법 통과…AI로 생체 정보 수집 금지, 중앙일보, 2024/3/14

- 6) 정인호 기자, AI 규제 선도하는 미국과 유럽…우리 대응은?, 주간 한국, 2023/11/10

- 7) Cao, S., Gomez, C., & Huang, C. How Time Pressure in Different Phases of Decision-Making Influences Human-AI Collaboration. Proceedings of the ACM on Human-Computer Interaction, 2023

- 8) Sharan, N., & Romano, D. The effects of personality and locus of control on trust in humans versus artificial intelligence. Heliyon, 6., 2020

- 9) Lee, M., & Chew, C. Understanding the Effect of Counterfactual Explanations on Trust and Reliance on AI for Human-AI Collaborative Clinical Decision Making. Proceedings of the ACM on Human-Computer Interaction, 2023

- 10) 윤영주 기자, 초지능 AI 막지 못한다- 컴퓨터 과학자들의 경고, AI 타임즈, 2021/1/13

- 11) 김외 기자, AI 안경 쓴 경찰, 당신 범인이지…촘촘해지는 중국 감시사회, 한겨레, 2019/10/19

- 12) 조영빈 기자, 인구 14억명 다 알아보는 중국 안면인식 빅브러더…정말 없앨까?, 한국일보, 2023/10/23

- 13) 이예린 기자, AI 악용 범죄, 올 전세계 피해액 190조원, 문화일보, 2023/7/18

- 14) Patarlapati, N. Unmasking Reality: Exploring the Sociological Impacts of Deepfake Technology. International Journal for Research in Applied Science and Engineering Technology., 2023

- 15) Vaccari, C., & Chadwick, A. Deepfakes and Disinformation: Exploring the Impact of Synthetic Political Video on Deception, Uncertainty, and Trust in News. Social Media + Society, 2020

- 16) Ali, A., Jadoon, Y., Farid, Z., Ahmad, M., Abid, N., Alzoubi, H., & Alzoubi, A. (2022). The Threat of Deep Fake Technology to Trusted Identity Management. International Conference on Cyber Resilience, 2022

- 17) 조진서, 인공지능 오류로 사고 땐 누구 책임? 법적 문제 정리돼야 시장이 커진다, 동아비지니스 리뷰, 2017/7

- 18) 강광우 기자, 올해 AI가 인간 일자리 5% 뺏는다…커지는 AI發 구조조정 우려, 중앙일보, 2024/1/16

- 19) 이하원 기자, 일자리 오히려 늘 것…AI가 업무에 미치는 영향, AI 타임즈, 2022/9/1

- 20) Howard J. Rankin, The Psychological Impact of Artificial Intelligence, Psychology Today, 2023/8/23

- 21) Johnson, D., & Verdicchio, M. AI Anxiety. Journal of the Association for Information Science and Technology, 2017